百度无法收录网站排查方法

来源:本站原创

点击数: 次

发布时间:2020年11月03日

问题描述:例如有些政府网站,百度始终无法收录;

问题分析:针对于我们公司开发的系统,直接分析下面几个原因:

查看robots.txt文件是否禁止爬虫抓取数据。

手动提交页面让百度收录,后面观察是否被收录;

检查服务器前端的安全设备是否有阻止,爬出无法访问到源服务器。

问题解决:

1.检查robots文件是否屏蔽了百度蜘蛛:robots文件会屏蔽百度或网站部分页面,导致蜘蛛进不了门。

2.查看日志:查看百度蜘蛛爬行记录bai的方法:第一,前往空间服务器,下载网站日志。第二,打开网站日志文件,搜索:Baiduspider。百度(Baidu)爬虫名称:Baiduspider。第三,鉴别百度蜘蛛的真伪。由于很多站长工具会模拟百度蜘蛛的名称来爬抓网站,因此,需要我们鉴别百度蜘蛛的真伪。鉴别方法:开始—运行—输入 cmd ,用命令nslookup +ip只要是百度的IP段,代码中会有出现:name:baiduspider,如果没有出现,那就不说不是真的百度IP段第四,可以通过日志工具来查看网站日志。例如:光年日志。

3.检查服务器前端的安全设备(waf等)是否有阻止,爬出无法访问到源服务器。

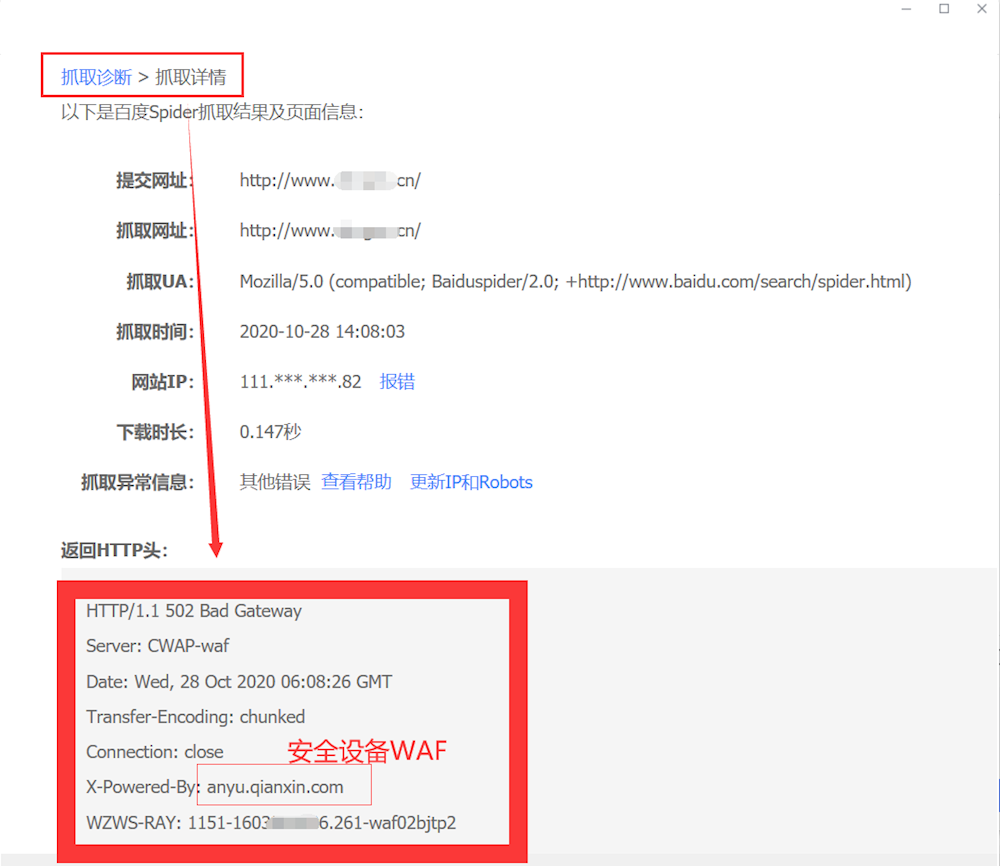

4.要具体分析出爬虫抓取异常的原因,可以利用站长工具进行分析排查。

通过抓取异常信息判断出:是网关处出现了错误,其中里面还显示waf设备齐安信;这时就让安全设备技术检查策略是否有限制,因为策略限制了百度爬出抓取内容,爬虫被挡在门外无法访问服务器,所以一般通过修改策略后爬虫就可以访问源服务器。

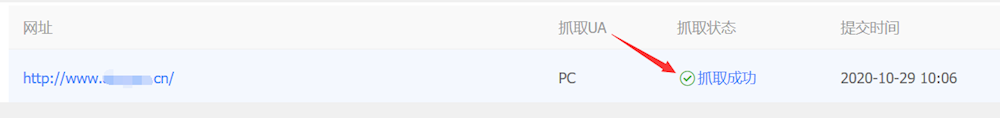

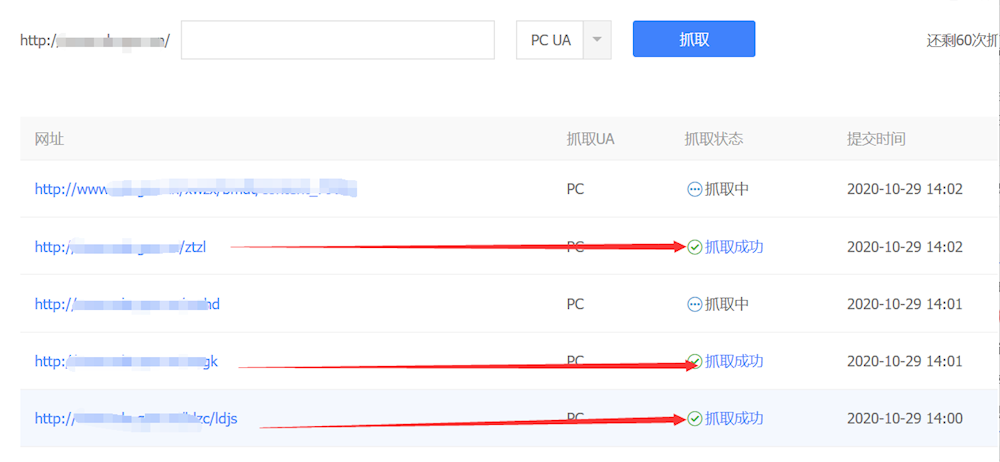

进行普通收录:资源提交—普通收录-手动提交,填写主要的地址,首页、频道页地址,让百度快点收录

全部抓取成功。